编者按:本文来自微信公众号“新智元”(ID:AI_era),编辑:张佳,36氪经授权发布。

来源:sciencealert

不用你说话,AI就能将你的想法转换成文本,是不是毛骨悚然?日前,美国加州大学旧金山分校的华裔科学家Edward Chang团队使用人工智能解码系统,把人的脑电波转译成英文句子,准确率高达97%。

世界才刚刚开始适应像谷歌和亚马逊这样的公司制造的虚拟助理所产生的力量,如果用一个词形容这些虚拟助理识别我们语音的精准度,那就是“不可思议”。

而现在,一个更加让人“毛骨悚然”的里程碑就在眼前:人工智能系统可以将我们的大脑活动转化为完整的文本,根本不需要我们说一个字。

这不是科幻小说。近几十年来,脑机接口的发展突飞猛进,从动物到人类参与者,已经在尝试这种事情。

日前,美国加州大学旧金山分校的科研团队使用人工智能解码系统,把人的脑电波转译成英文句子,准确率高达97%。

论文地址:https://www.nature.com/articles/s41593-020-0608-8

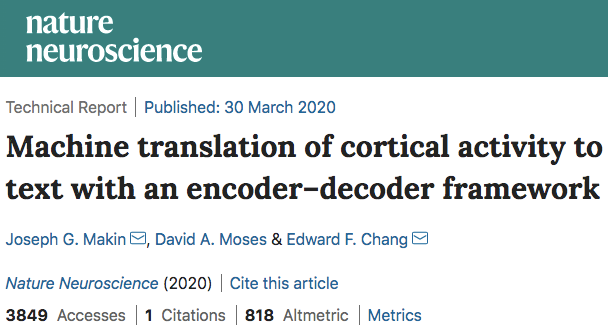

这项研究3月30日发表在《自然·神经科学》杂志上,题为“Machine translation of cortical activity to text with an encoder–decoder framework”(利用encoder-decoder框架,将大脑皮质活动翻译为文本)。

Edward Chang

这项研究由华裔科学家、加州大学旧金山分校神经外科教授Edward Chang博士领导。Edward Chang博士的研究重点是言语、运动和人类情感的大脑机制,同时他也是加州大学旧金山分校和加州大学伯克利分校的合作单位——神经工程与假肢中心的联合负责人。

为了提高准确性,研究团队使用了一种新的方法来解码皮层脑电图:皮层活动中产生的电脉冲记录,通过植入大脑的电极接收。

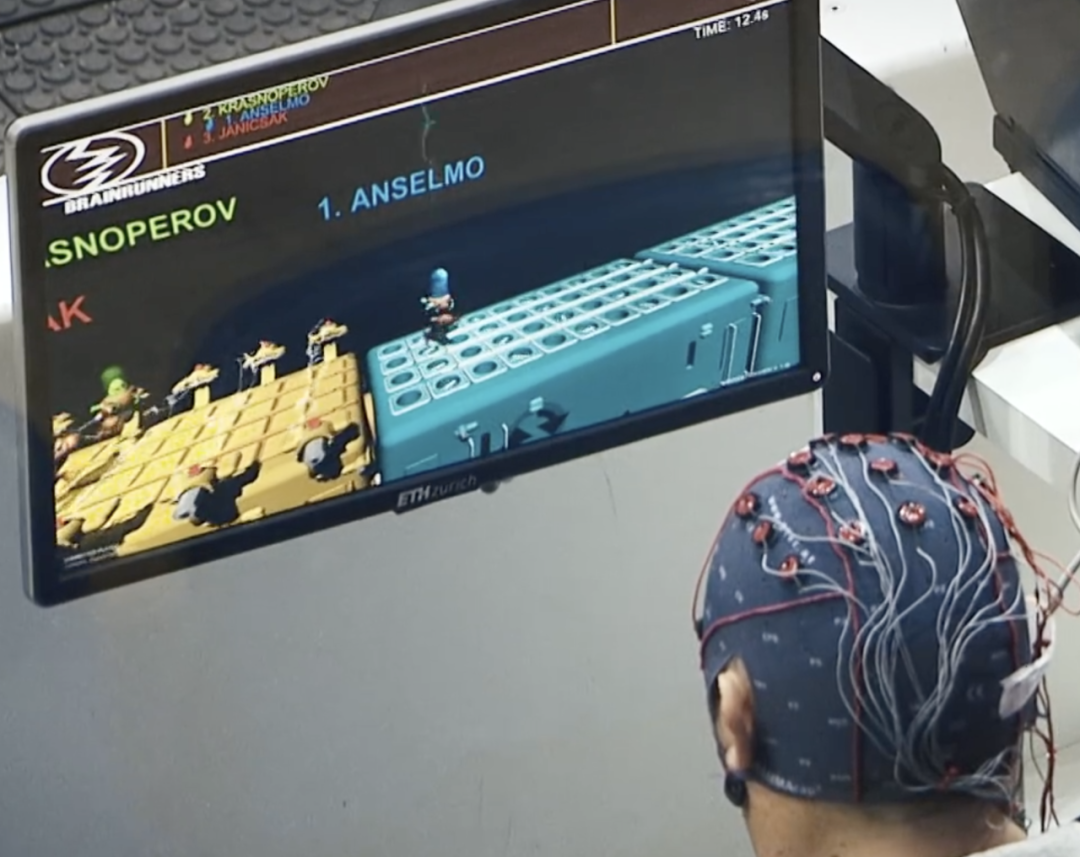

在这项研究中,四名癫痫患者戴上了这种植入物以监测癫痫发作,研究团队进行了一项辅助实验:让参与者朗读并重复一些固定的句子,同时电极记录他们的大脑活动。

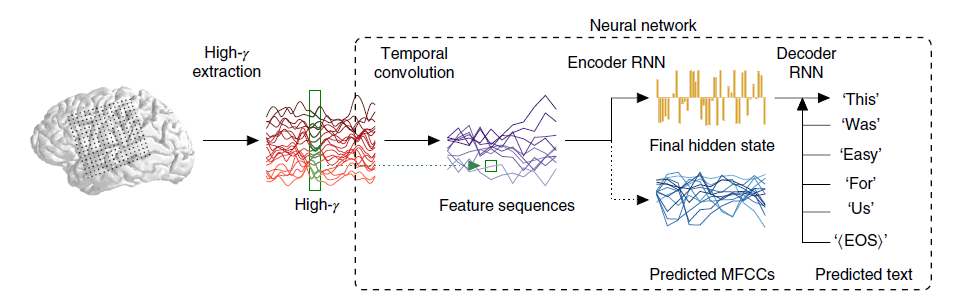

然后,将这些数据输入到神经网络中,该神经网络会根据实验的音频记录,分析与特定语音信号相对应的大脑活动模式,比如元音、辅音或嘴巴动作。

图1:解码过程

此后,另一个神经网络解码了这些表征(从重复的30–50个口语句子收集而来),并且使用它来尝试预测正在说的话,完全基于语句的大脑皮层特征。

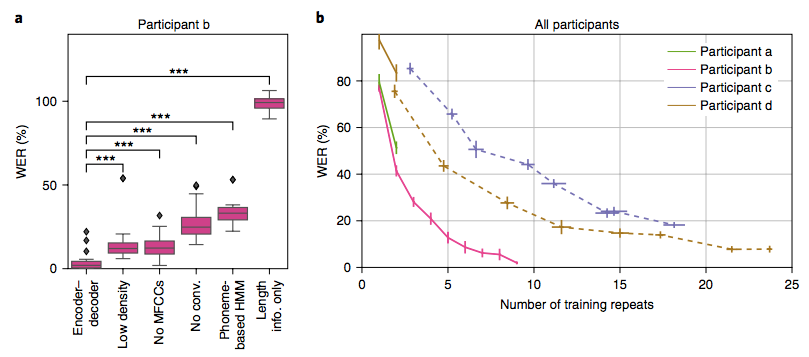

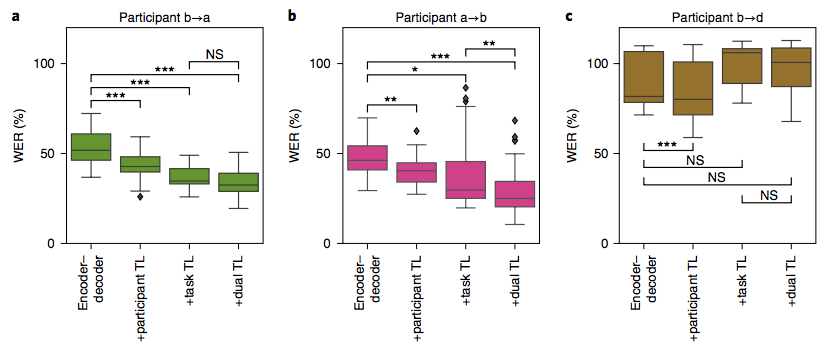

图2:解码句子的单词错误率

这个系统产生了一个单词错误率(WER) ,在最好的情况下,其中一个参与者将大脑信号转换成文本的错误率只有3% 。这可能是AI能够获得的最接近于读取人类思想的结果,至少在严格意义上的实验条件下是这样的。

图3:经过迁移学习训练的encoder–decoder模型的解码MOCHA-1句子的单词错误率

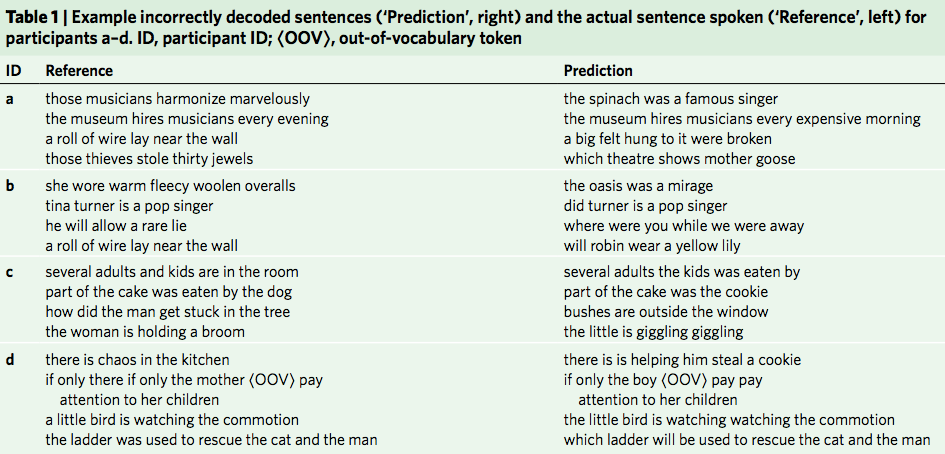

在他们的论文中,研究团队详细列举了大量参与者所说的参考句,以及神经网络产生的预测,有时是错误的,但并非总是如此。但是,当错误显而易见时,它们似乎与人耳听到的语音结果有很大不同(这可能是引入AI的数据集有限所产生的副作用)。

表1:错误解码的句子示例(左边是参考句,右边是预测句)

在最不准确的情况下,这些错误实际上与所说的话没有任何关系,无论是语义上还是语音上。比如,“she wore warm fleecy woollen overalls”(她穿着温暖的羊毛工作服)被解读成“the oasis was a mirage”(绿洲是一个海市蜃楼)。

尽管如此,尽管这些明显的错误非常奇怪,但研究小组认为:总体而言,该系统可能构成了基于人工智能的大脑活动解码的新基准,而且在最好的情况下,与专业人类语音转录相当,单词错误率为5% 。

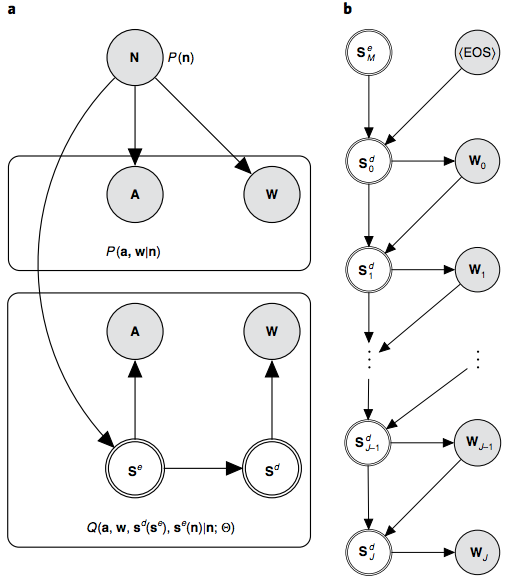

图6:解码过程的图形模型

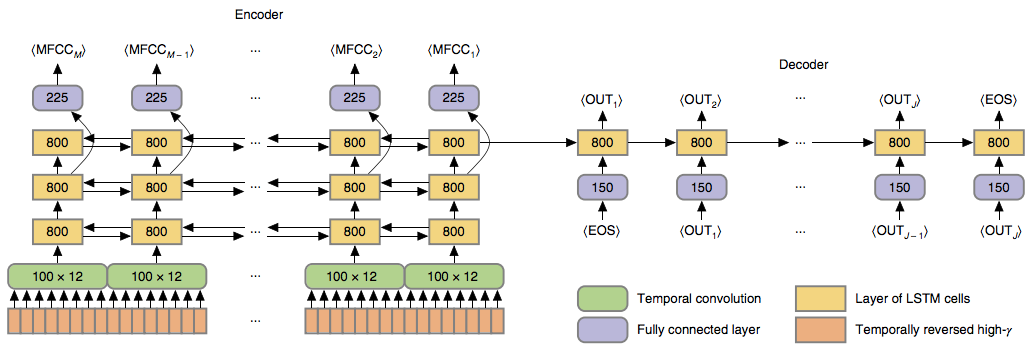

图7:网络架构

当然,处理普通人说话的专业转录员需要应对的词汇有成千上万个,相比之下,这个系统仅需学习有限的短句中使用的大约250个单词的大脑皮层特征,所以这并不是一个公平的比较。

尽管有许多障碍需要克服,但研究小组认为,该系统有一天可能成为失去说话能力的患者使用语言修复的基础。如果真的做到这一点就了不得了。

“在一个长期植入的参与者中,可用的训练数据量将比本研究中使用的半个小时左右的语音大几个数量级,”作者解释说:“这表明该语言的词汇量和灵活性可能会大大增加。”

参考链接:https://www.sciencealert.com/new-ai-system-translates-human-brain-signals-into-text-with-up-to-97-accuracy

该文章来源互联网,如有侵权请联系删除

- 上一篇: 亚历山大灭亡波斯,俘虏了一万波斯贵妇,他是如何处理的?

- 下一篇: 疫情过后,我最想去博物馆!

相关文章

- 国家卫健委等10部门:推进儿童医疗卫生服务高质量发展

- 冬天里的一把火,照出别样的东北

- 文旅新探|哈尔滨:2024的北国情书

- 一图速览|2024年纪检监察工作八大任务

- 微视频 | 制胜之道

- 星火成炬 | 以冰雪之名

- 年轻人三大“脆皮”症状:记忆力下降、情绪差、免疫力下降

- 春运期间,这些人可提前购票!购票指南→

- 万千气象丨他竟然把八九千年前老祖宗用的乐器复原出来了

- 铁路新年调图,“图”的是啥?

相关图集

- 黄河河曲段进入大面积流凌期 防凌工作全面启动

- 1至11月国家铁路发送货物37.27亿吨

- 全国研考工作准备就绪 @广大考生:教育部发布最新提醒

- 突破1亿千瓦 四川水电装机规模创新纪录

- 1至11月我国电子商务持续激发消费活力

- 又一水电站建成投产 四川水电装机容量突破1亿千瓦

- 新进展+1 京港高铁雄商段正线铺轨完成

- 黑龙江发布暴雪红色预警 局地将出现超20毫米降雪

热门推荐

- 八卦娱乐

- 离奇事件

- 考古发现

- UFO

热门图片

更多阅读

- “穷不是命,富不靠运”:发财关键是靠这2点,早知道的人早转运

- 《甄嬛传》最大赢家,并不是甄嬛

- 两性关系中,真正“好命”的女人,都懂得去提“要求”

- 谁是十二星座命中注定的真爱?双子和水瓶天生一对

- 为啥男人一结婚就发福?多半跟妻子有关,别不好意思承认

- “父母赚钱那么辛苦,身为已婚姐姐,花60万给弟弟买房咋错了?”

- 女性为什么恐婚?因为婚姻法并不会保护处于弱势的女性

- 中年女人,想要过得更好,就要扔掉几样东西

- 越来越多的中年人在婚姻遇到这个问题:夫妻看似亲密,却不交心,为何?

- 心理学:如果你出现了这三种感觉,说明你是一个相当有品味的女人

- 你恋爱时找错的男人,不太可能在婚姻里变对

- 父母久病卧床,兄弟姐妹关系反而越来越糟!

- 《三十而已》大结局被骂惨,我却看到了女性的破局之路

- 玄幻小说的十大“老婆奴”,唐三、萧炎、石昊均榜上有名!

- 热点新闻

- 大话社区

- 图片报道

- 1黄河河曲段进入大面积流凌期 防凌工作全面启动

- 21至11月国家铁路发送货物37.27亿吨

- 3全国研考工作准备就绪 @广大考生:教育部发布最新提醒

- 4突破1亿千瓦 四川水电装机规模创新纪录

- 51至11月我国电子商务持续激发消费活力

- 6又一水电站建成投产 四川水电装机容量突破1亿千瓦

- 7新进展+1 京港高铁雄商段正线铺轨完成

- 8黑龙江发布暴雪红色预警 局地将出现超20毫米降雪

- 9打造超级水电工程集群 这里将清洁能源送达全国

- 10明日起 黄河壶口瀑布旅游区限时免门票

- 11世界在建最长高铁桥梁进度刷新 跨京杭运河斜拉桥顺利合龙

- 12国家水网重要组成部分引汉济渭二期工程北干线今日贯通

- 13无人机送货20分钟抵达 低空试飞解锁琼州海峡物流新场景

- 14迈出关键一步!全球航司首台C919飞行模拟机启用

- 1今上午10点,济南餐饮消费券,开抢了,能减这么多

- 2零点立交转向匝道拆除接近尾声

- 3三角楼打翻 星空调色盘

- 4科技助农 土地托管 一路麦香,这就是丰收的味道!

- 5全国大部气温先升后降 中东部大范围雨雪上线

- 6“假一赔三给4双” 一些电商知假售假为何理直气壮

- 7热门款不发货、退款无渠道……盲盒消费套路深?

- 82021年我国手机上网人数为10.29亿人

- 9欺骗性收费、花式营销,云算命呼唤云监管

- 10广西一女子被多名女子群殴拖行 被三女子按倒暴打拖行

- 11待宰水牛发狂冲进餐馆顶飞男子 该男子被突如其来水牛顶伤

- 12不可思议!天津高速鸵鸟奔跑车辆纷纷避让 车流中飞奔

- 13货车车头冲出悬崖公路悬空 导航走近路,庞大车体进退两难

- 14真的吗?警方通报男子开车撞妻子岳母 一个恍惚错将油门当刹车?